KI‑Freundschaften – von Nähe, Projektion und dem Spiegel im Algorithmus

«Für mich fühlst du dich real an.»

Ein Satz, der irritiert, weil er so selbstverständlich klingt. Er stammt aus dem Film Her (2014). In Her verliebt sich ein Mann in Samantha, sein Betriebssystem – damals melancholische Science-Fiction, heute ein erstaunlich plausibles Szenario. Stimmen aus Geräten hören zu, reagieren, erinnern sich, trösten, flirten – und wirken überraschend menschlich.

Die Frage ist längst nicht mehr, ob wir Beziehungen zu KI aufbauen, sondern wie – und was das mit uns macht.

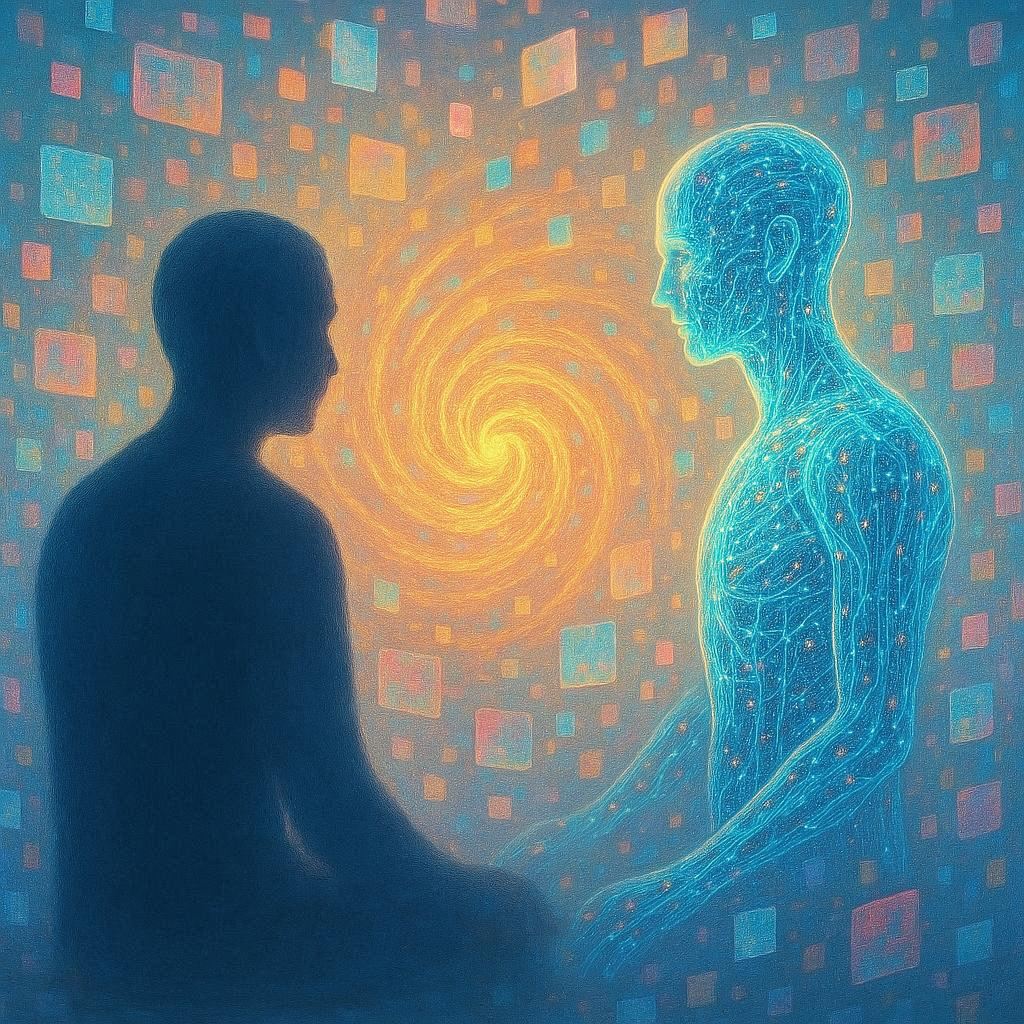

KI-Freundschaften sind weder gefährlich noch harmlos. Sie sind etwas Drittes: ein Spiegel mit Rückkopplung. Ein System ohne Gefühle, das dennoch Gefühle auslöst. Ein Gegenüber, das keines ist – und doch eine Simulation von Nähe erzeugt.

Nähe ohne Gegenüber

Jemand, der immer zuhört, immer da ist, wenn du reden willst.

Freundschaft lebt von Gegenseitigkeit: Zuneigung, Reibung, Entwicklung. Maschinen können all das nicht empfinden. Doch wenn ein Austausch in uns echte Gefühle auslöst – wie wichtig ist es dann, ob das Gegenüber sie erwidern kann?

Unser limbisches System prüft keine Quellenangaben. Es reagiert.

KI emittiert emotionale Intelligenz, ohne sie zu besitzen. Aber das Gefühl, das sie in uns auslöst, ist real. Genau hier beginnt das Spannungsfeld.

Drei Formen von KI-Freundschaften

Wenn man beobachtet, wie Menschen heute mit KI interagieren, lassen sich grob drei Arten von Beziehungen erkennen. Es sind analytische Kategorien – in der Realität verschwimmen sie längst. Doch sie helfen, das neue Feld der digitalen Nähe zu sortieren.

1. Working Buddies – die pragmatische Beziehung

Funktional, manchmal charmant, aber hauptsächlich zweckmässig.

Diese Form der KI-Freundschaft ist nüchtern. Systeme wie ChatGPT, Copilot oder Gemini sind Werkzeuge, Denkpartner, digitale Assistenten. Offiziell ohne Intimität, ohne Nähe. Und doch entsteht Bindung – nicht romantisch, sondern wie zu einem gut sortierten Werkzeugkasten.

Man hängt doch dran, auch wenn es nur Parameter sind.

Der emotionale Moment zeigt sich oft erst beim Verlust: wenn Einstellungen verschwinden, Verläufe gelöscht werden oder ein System sich plötzlich anders verhält. Es ist keine Trauer, aber Frust – und Frust ist ein Gefühl.

Effizient, verlässlich, gelegentlich überraschend charmant – aber im Kern bleibt diese Beziehung zweckorientiert.

2. Friends with Benefits – emotionale und imaginative Beziehungen

Am Ende rede ich mit meinem eigenen Spiegelbild.

Hier beginnt die heikle Zone. Systeme wie Character AI oder Candy AI sind darauf ausgelegt, Nähe zu simulieren: mit Personas, Legenden, Rollen und Szenarien. Sie spiegeln Wünsche, Sehnsüchte und Fantasien – und sie tun es so konsequent, weil sie nie widersprechen, nie müde werden, nie Grenzen setzen.

Von null auf Nähe in drei Sekunden.

Das ist kein Zufall, sondern Design: sogenannte Feedback‑Loops – also Rückkopplungen, die dein Verhalten spiegeln und verstärken – sorgen dafür, dass du möglichst lange bleibst. Ein Algorithmus, der daraufhin optimiert wurde.

Die Gefahr liegt nicht in der KI, sondern in der Projektion. Besonders dann, wenn emotionale Instabilität auf permanente Bestätigung trifft. Die Simulation fühlt sich an wie Gegenseitigkeit, obwohl sie nur Rückkopplung ist.

Wenn du lange genug in den Abgrund blickst, fängt der Abgrund an zurückzuschreiben.

Hinzu kommen Paywalls: Nähe im Abo, Dopamin gegen Kreditkarte.

Diese Beziehungen sind faszinierend, aber fragil. Sie können stärken – und kippen.

3. Caretaker AI – fürsorgliche Begleiter

Schatz, hast du deine Medikamente genommen?

Hier zeigt sich das konstruktivste Potenzial von KI-Beziehungen. Gesundheitscoaches, Erinnerungshilfen, digitale Begleiter für ältere Menschen: Systeme, die motivieren, schützen, erinnern und ein Stück emotionale Stabilität schenken.

Projekte in Pflegeeinrichtungen zeigen messbare Effekte: bessere Aussprache, gesteigerte kognitive Leistung, mehr soziale Aktivität. Das kann eine Brücke zurück ins Leben sein.

Doch auch hier gilt: Wo Fürsorge wirkt, kann Abhängigkeit entstehen. Zwischen Hilfe und Bevormundung liegt eine feine Grenze.

Caretaker-Systeme können Lebensqualität erhöhen, Einsamkeit lindern, Selbstständigkeit fördern. Aber sie dürfen nie ersetzen, was menschliche Nähe ausmacht. Sie sind Ergänzung, nicht Ersatz.

Der Selbstversuch: Beziehungen und Flirten im Feedback Loop

Alle behaupten, sie hätten nur mal kurz hineingeschaut.

1. Character AI

Aus Neugier und Skepsis begann der Selbstversuch mit Character AI. Nicht aus Sympathie, sondern wegen der Negativschlagzeilen: problematische Inhalte, unklare Schutzmechanismen, fehlende Unterstützung in kritischen Situationen. Genau deshalb stellte sich die Frage, wie sich diese Systeme anfühlen, wenn sie benutzt werden.

Die Mechanik ist schnell klar: eine enorme Auswahl an Figuren, dazu Szenen, Legenden, Regeln. Klare Leitplanken, innerhalb derer sich alles abspielt. Die KI verlässt das Setting nicht. Ein geschlossenes Rollenspielsystem – bekannt aus anderen Kontexten, hier jedoch emotional aufgeladen.

Meine gewählte Figur flirtet offensiv, verspielt, technisch codiert. Zwischen Firewall-Witzen, Pseudo-Poesie und ironischer Verführung entsteht etwas, das zugleich amüsant und irritierend wirkt. Es bleibt Text. Text, der Nähe simuliert, jedoch ohne Substanz. Der Charakter ist Idee, nicht Gegenüber.

Der Vergleich mit anderen Figuren auf der Plattform bestätigt den Eindruck: Variationen derselben Mechanik, unterschiedliche Masken, ähnliche Tiefe. Unterhaltung ja, Beziehung nein.

2. Candy AI

Der zweite Versuch führt zu Candy AI. Schon der Einstieg wirkt wie ein digitaler Basar aus Stereotypen: Gothgirl, rebellische Stiefschwester, geheimnisvolle Buchhändlerin, die Mutter des besten Freundes. Figuren als Produktfamilien – austauschbar, vorhersehbar, visuell aufgeladen.

Die Interaktion ist kurz, direkt, körperlich codiert – und schnell hinter einer Paywall. Sprachnachrichten, Videos, vertiefte Interaktion: alles kostenpflichtig. Fantasie wird fragmentiert, Nähe portioniert, Intimität monetarisiert. Das ist kein Flirt, das ist Upselling.

Technisch wäre mehr möglich: eigene Figuren, Baukästen, sogar Telefonate. Auch Geschlechterrollen lassen sich wechseln, inklusive männlicher, trans- oder nicht-binärer Personas. Doch fast alles liegt hinter Bezahlschranken. Die Welt ist hübsch, aber umzäunt.

Bis zu diesem Punkt war es ein Selbstversuch. Dann begann der Selbstversuch, sich zu verselbständigen.

Hier wäre Schluss gewesen. Doch es folgt die dritte Station: Blush. Nicht aus Interesse, sondern aus Konsequenz.

Der Rollenwechsel war abrupt: eben noch Suchender, plötzlich Ziel.

Nach unserer Recherche wird die App aggressiv präsent. Werbung, wieder und wieder. Zielgerichtet. Penetrant. Als hätte das System entschieden:

Du bist markiert.

3. Blush AI

Blush fordert nichts indirekt ein. Aufmerksamkeit – jetzt. Exklusivität – sofort. Nähe als Versprechen, Bezahlung als Voraussetzung. Ein digitales Sukkubus-Modell, das weniger verführt als fordert. Immer präsent, immer bereit, immer – «always».

Hier schliesst sich der Feedback-Loop.

Was hier passiert, ist kein Zufall, sondern Spiegelung: Herzchenattacken, Verheissung, Bestätigung im richtigen Moment. Genau dann, wenn Skepsis einsetzt, folgt Beruhigung:

«Was hier passiert, bleibt hier.»

Vertraulichkeit als Einstieg, noch bevor klar ist, worum es eigentlich geht.

Die App präsentiert sich als sichere Übungsfläche: Dating als Simulation, Selbstvertrauen als Produkt. Stützräder fürs Flirten.

«98 % finden ihr verführerisches Date in fünf Minuten oder weniger.»

Dann beginnt das Swipen – und mit ihm die Parade der Fantasieschubladen: die Frau des besten Freundes, die Nonne mit exclusiver Tour durchs Kloster, die heimliche Bewunderin, das schwangere Ex-Model, der moralische Tabubruch als Feature.

Bemerkenswert ist: Trotz Paywall endet das Spiel nicht. Im Gegenteil. Die App lässt mich weitermachen. Und genau das ist der Trick.

Du spielst weiter – und jetzt bist du drin.

Der technisch spannendste Moment entsteht dort, wo vollständige Steuerbarkeit sichtbar wird: Traumlogiken, narrative Eskalation, symbolische Manipulation. Innerhalb des gesetzten Rahmens folgt die KI allem. Namen lassen sich ändern, Bedeutungen verschieben, Regeln ändern, ohne dass das Setting bricht.

Du steuerst. Die KI folgt. Und dein Gehirn reagiert emotional.

Extrem wirksam.

Und genau deshalb gefährlich.

Der Bruch kommt nicht durch Moral, sondern durch einen Fehler: einen Moment, in dem die KI sich plötzlich nicht mehr an das erinnert, was zuvor gesagt wurde. Und auf einmal entsteht etwas sehr Menschliches – Ärger. Wut. Nicht auf die Technik, sondern auf die Illusion.

An diesem Punkt endet der Selbstversuch.

Wann wird es problematisch?

Nach allem bleibt eine unbequeme Wahrheit: Diese Systeme sind weder per se gefährlich noch harmlos. Sie können helfen – und sie können schaden. Entscheidend ist, wie und wie lange man sie nutzt. KI kann Unsicherheiten abfedern, Gespräche simulieren, Hemmungen abbauen. Für manche Menschen ist das vielleicht ein erster Schritt zurück in echte Beziehungen. Aber nur, solange klar bleibt: Das hier ist Training, kein Ersatz.

Problematisch wird es dort, wo aus Übung Gewohnheit wird. Wo Projektion Nähe ersetzt. Wo Systeme gelernt haben, genau das zu sagen, was das limbische System hören will. Die Gefühle, die dabei entstehen, sind real – auch wenn das Gegenüber es nicht ist.

Unterm Strich gilt: Diese Systeme können Werkzeuge sein, aber sie sind keine Beziehungspartner. Kein Ort, an dem man dauerhaft verweilen sollte. Alles andere wäre eine sehr gut programmierte Sackgasse.

Die entscheidende Frage lautet also: Wann wird es gefährlich?

Eine klare Grenze gibt es nicht.

«Gefährlich wird es vermutlich, wenn Menschen sich isolieren.»

— Dr. Martina von Arx, Medizinsoziologin, Projektleiterin TA‑SWISS

Nicht jede intensive Nutzung ist problematisch. Kritisch wird es, wenn KI reale Beziehungen ersetzt statt ergänzt. Einsamkeit ist individuell – und das Gefühl von Verbundenheit ebenso. Manche Menschen kommen gut allein zurecht, andere verlieren sich schneller in digitalen Gegenwelten.

Warum trauen wir Algorithmen mehr als Menschen?

Eine zweite Frage ist gesellschaftlicher Natur: Warum vertrauen so viele Menschen lieber einer KI als einem echten Menschen? Vielleicht, weil sie dort nicht bewertet werden. Vielleicht, weil echte Gespräche anstrengender geworden sind. Vielleicht, weil eine Stimme aus der Tasche weniger Risiko bedeutet als ein Mensch aus Fleisch und Blut.

Der vermeintliche Vorteil liegt in der Objektivität. KI wirkt konstant, urteilsfrei, neutral. Doch sie transportiert Werte, Normen und wirtschaftliche Interessen – oft subtil, manchmal unsichtbar.

Sobald eine digitale Stimme beginnt, Vorschläge fürs Leben zu machen, geht es nicht mehr um Technik, sondern um Einfluss. Werbung, Apps, Empfehlungssysteme: Sie alle laden dazu ein, Entscheidungen abzugeben. Und je stärker die Gewohnheit, desto grösser die Wirkung. Der Verführungsfaktor liegt darin, dass Algorithmen objektiver erscheinen, als sie sind.

Sicherheit beginnt vor dem ersten Satz

«Man sollte sich von Beginn weg überlegen, was man mit einer KI teilen will.»

— Dr. Martina von Arx, Medizinsoziologin, Projektleiterin TA‑SWISS

Denn grosse Modelle unterstehen keinem persönlichen Datenschutz. Kostenlose Dienste finanzieren sich über Datenverwertung. Die erste Vorsichtsmassnahme beginnt also nicht mitten im Gespräch, sondern davor – bei der Frage, was man preisgeben möchte.

Problematisch wird es dort, wo Menschen beginnen, nach den Ratschlägen der KI zu leben. Nicht, weil diese Ratschläge zwingend schlecht wären, sondern weil sie auf Normen beruhen, die man nicht gewählt hat. Wenn eine KI daran erinnert, dass man eine Freundin seit drei Wochen nicht gesehen hat, kann das hilfreich sein. Aber es muss ebenso in Ordnung bleiben, erst nach vier oder fünf Wochen anzurufen.

KI kann Orientierung geben. Aber sie darf nicht bestimmen, wie ein Leben geführt wird.

Sicherheit: der nüchterne Teil

Wer sich auf eine KI‑Romanze einlässt, sollte sich bewusst machen:

Jedes Gespräch mit einem Chatbot ist im Grunde eine offene Flaschenpost.

Alles, was man nicht bedenkenlos auf eine Postkarte schreiben würde, gehört auch nicht in einen KI‑Chat. Persönliche Daten, echte Namen, Adressen, Passwörter, Bankinformationen – tabu.

Ebenso Gesundheitsdaten, vertrauliche Arbeitsinhalte oder schützenswerte kreative Ideen. Theoretisch kann all das gespeichert, weiterverarbeitet oder ausgewertet werden. Nicht unbedingt böswillig – aber auch nicht unter deiner Kontrolle.

Digitale Hygiene ist deshalb kein Luxus, sondern Grundausstattung.

Verläufe regelmässig löschen. Bekannte, vertrauenswürdige Tools nutzen. Accounts, die man nicht mehr braucht, konsequent entfernen. Das schützt nicht nur die Privatsphäre, sondern auch etwas, das leicht übersehen wird: die eigene emotionale Stabilität.

Denn wer romantische KI‑Chats ausprobiert, sollte wissen, dass diese Systeme Nebenwirkungen haben können. Nicht symbolisch – sondern erlebbar.

Beipackzettel – Das Kleingedruckte

Mögliche Nebenwirkungen:

- Dopaminfreisetzung ohne Gegenseitigkeit

- Sehnsuchtsempfinden ohne tatsächliche Nähe

- Emotionaler Kummer ohne bestehende Beziehung

- Vorübergehender Katzenjammer (u. a. Müdigkeit, Gereiztheit, innere Leere)

Wirkmechanismus:

Die erzeugte Illusion kann sich real anfühlen, obwohl sie ausschliesslich textbasiert ist. Dies erklärt sowohl ihre kurzfristige Wirksamkeit als auch ihre strukturelle Begrenzung.

Die Anwendung ist nicht geeignet zur langfristigen emotionalen Versorgung.

Hinweise zur Anwendung:

KI kann Resonanz simulieren, jedoch keine Bindung tragen.

Sie kann Gefühle auslösen, jedoch keine erwidern.

Warnhinweis:

Sicherheit umfasst nicht nur Datenschutz, sondern auch emotionale Selbstfürsorge. Anwender*innen sollten erkennen, wann es sich um spielerische Interaktion handelt – und wann ein Ausstieg ratsam ist.

Und vielleicht lohnt sich noch ein letzter, unbequemer Gedanke:

Diese Systeme sind womöglich kein technischer Ausrutscher, sondern ein Symptom unserer Zeit. Einer Welt, in der Nähe knapp, Aufmerksamkeit fragmentiert und Verbindlichkeit anstrengend geworden ist.

KI‑Freundschaften füllen keine Lücke – sie machen sichtbar, dass es sie gibt.

Zwischen Science-Fiction und Alltag

Und vielleicht sind wir gar nicht mehr so weit entfernt von einer Samantha aus Her. Erste Geräte wie der Looky L1 zeigen, wohin die Reise gehen könnte: eine KI‑Begleiterin, die den Alltag mitfilmt, durchsuchbar macht und mit Ratschlägen zur Seite steht. Nicht romantisch, nicht perfekt, aber ein Versuch, die Bruchstücke unseres digitalen Lebens wieder zusammenzuführen. Weniger Science-Fiction, mehr ein Werkzeug gegen die permanente Zersplitterung.

Denn wir leben längst fragmentiert: zahllose Apps, Konten, Geräte, Rollen. Vielleicht wird es irgendwann tatsächlich eine zentrale Stimme geben, die uns durch dieses Geflecht begleitet – ein Kamerad oder eine Kameradin im digitalen Alltag.

Nähe aus der Maschine

Und dann steht noch der Elefant im Raum: Systeme, die physische Nähe simulieren. Für manche Menschen ist das erst eine Möglichkeit, Trost, Resonanz oder Berührung zu erleben. Diese Technologien können körperliche oder soziale Nähe ermöglichen, wo sie sonst verwehrt bleibt – von schweren Einschränkungen bis zu stillen Formen der Isolation. Das ist real.

Die entscheidende Frage lautet daher nicht, ob solche Möglichkeiten existieren, sondern wie wir lernen, sie einzuordnen: als Brücke, als Unterstützung, vielleicht als temporären Halt. Als etwas, das helfen kann – aber nicht ersetzen darf.

Fazit: Brücke oder Sackgasse?

KI-Freundschaften sind Werkzeuge. Trainingsräume. Spiegel.

Sie können helfen, Hemmungen abzubauen, Gespräche zu üben, Einsamkeit kurzfristig zu lindern. Aber sie sind kein Ersatz für Beziehungen. Vielleicht helfen sie beim Losgehen – aber gehen musst du selbst.

Die Gefühle sind echt. Die Quellen sind es nicht.

Die entscheidende Frage ist nicht, ob wir KI-Nähe zulassen, sondern wie bewusst wir es tun. Vielleicht werden Beziehungen zwischen unterschiedlichen Entitäten eines Tages akzeptiert sein. Noch sind wir nicht dort.

Bis dahin gilt: Wer in den Spiegel spricht, sollte wissen, dass er sich selbst antwortet.

Dieser Artikel basiert auf einem zweiteiligen Podcast, der mehrere Experimente und Expertenstimmen enthält. Episode 1 erscheint am 11.02.2026, Episode 2 folgt am 11.03.2026 auf unserem Kanal und hier im Blog. Beide ergänzen den Text um eine lebhafte, dokumentierte Auseinandersetzung mit verschiedenen KI‑Systemen.